Comprender los datos Google Search Console

Publicado el 14 de enero del 2021 Índice de contenido

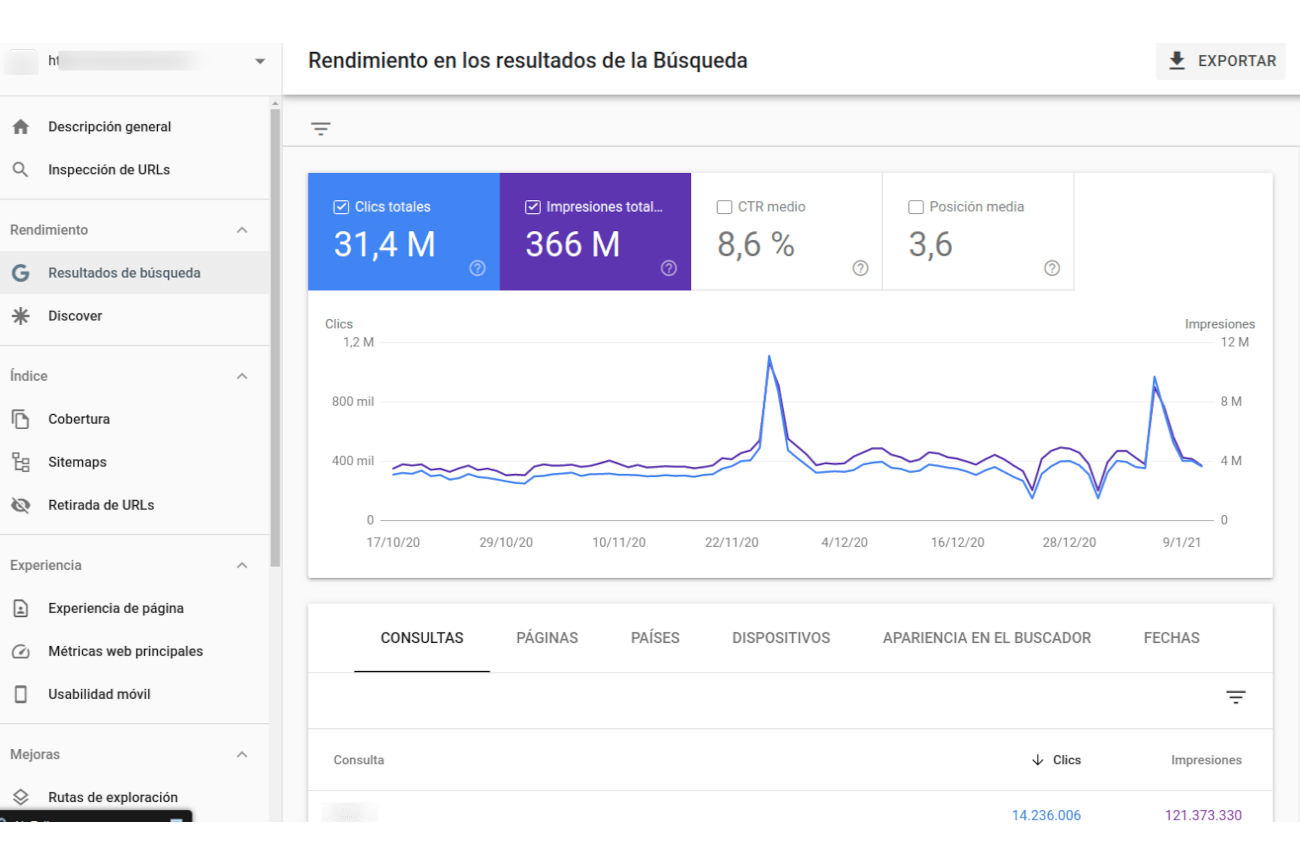

Algo que normalmente la gente que no se ha pegado mucho con los datos de Google Search Console no conoce es cómo funciona el límite de datos devuelto por Google Search Console cuando solicitamos datos del informe de rendimiento, ya sea a trávés de la API como de herramientas que suen la API (como PunkExport).

Aquí voy a hacer un resumen relámpago para intentar explicar cuáles son el máximo número de datos devueltos por la API, que siempre serán infinitamente muchos más que el interface web por el cual solamente devuelve 1.000 filas.

Límite de filas usando la API de Google Search Console

GSC muestra un máximo de 1.000 filas en sus informes via web, pero a través de la API da hasta 50.000 por cada solicitud.

Por ejemplo, al solicitar las URLs filtrando por un rango de fecha, pongamos, 1 mes, mediante el interface web obtendrás como mucho 1.000 URLs con sus métricas.

Una manera de obtener más datos (únicos) sería ir filtrando diá a día y descargarte cada día sus 1.000 URLs por lo que cuando termines de ir aplicando el filtro de fecha y descargar los datos para cada día de ese mes seguramente al final tengas más URLs únicas que las 1.000 que obtendrás si tienes un rango de fecha mayor., aunque obtendrás 1.000 cada día, muchas de ellas serán las mismas cada día, pero otras no. Es decir, de esta manera ya estás obteniendo más.

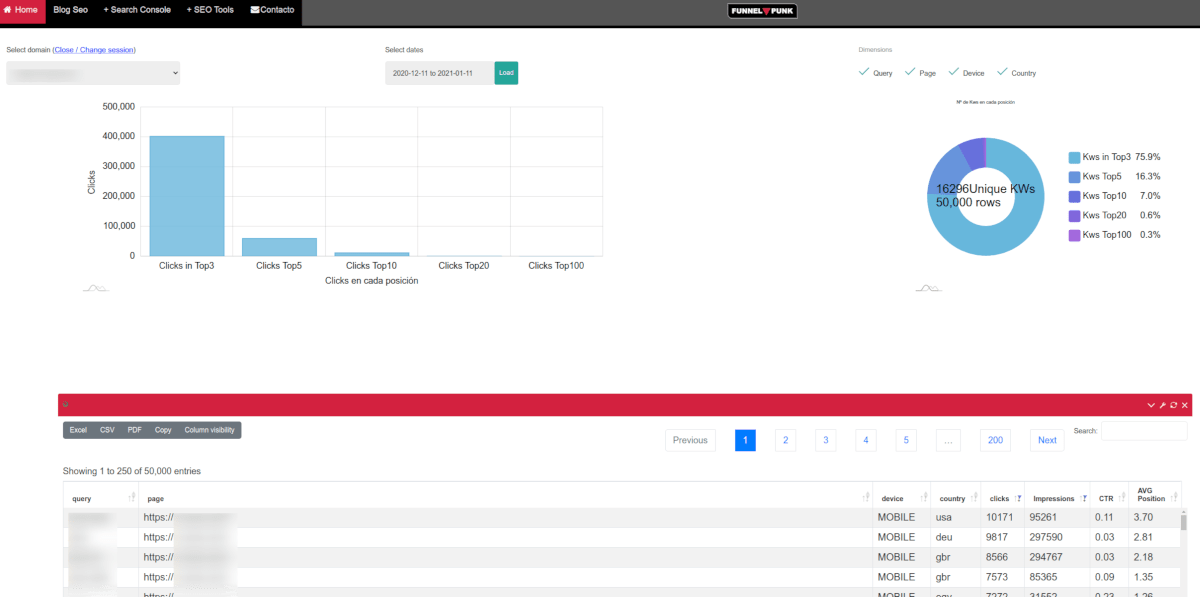

Con la API pasa lo mismo pero el límite por cada consulta son 50.000 (FILAS), date cuenta que pongo filas y no URLs y es que el límite lo establece el nú,ero de filas devueltas, máximo 50.000 y esto es importante porque depende de qué dimensiones solicites obtendrás más o menos URLs únicas..

Pongamos un ejemplo sencillo, imaginemos que el límite son 10 URLs, y solicitas las URLs del último mes y solo solicitamos la dimensión de "page" (URL), nos devolvería 10 filas

| Page | clicks | impresiones | posicion | ctr |

| URL 1 | 10 | 10 | 1 | 100 % |

| URL 2 | 9 | 9 | 1 | 100 % |

| URL 3 | 8 | 8 | 1 | 100 % |

| URL 4 | 7 | 7 | 1 | 100 % |

| URL 5 | 6 | 6 | 1 | 100 % |

| URL 6 | 5 | 5 | 1 | 100 % |

| URL 7 | 4 | 4 | 1 | 100 % |

| URL 8 | 3 | 3 | 1 | 100 % |

| URL 9 | 2 | 2 | 1 | 100 % |

| URL 10 | 1 | 1 | 1 | 100 % |

Nº de URLs únicas = 10 (ordenadas de mayor a menor número de clicks)

Ahora hacemos lo mismo pero también solicitamos la dimensión de país y todas las impresiones y clicks provienen de España, menos 3 impresiones de la URL1 que obtuvo 2 desde Francia y 1 desde Portugal, como nuestro límite es 10 filas mira lo que ocurre:

| Page | País | clicks | impresiones | posicion | ctr |

| URL 1 | esp | 7 | 7 | 1 | 100 % |

| URL 1 | fra | 2 | 2 | 1 | 100 % |

| URL 1 | por | 1 | 1 | 1 | 100 % |

| URL 2 | esp | 9 | 9 | 1 | 100 % |

| URL 3 | esp | 8 | 8 | 1 | 100 % |

| URL 4 | esp | 7 | 7 | 1 | 100 % |

| URL 5 | esp | 6 | 6 | 1 | 100 % |

| URL 6 | esp | 5 | 5 | 1 | 100 % |

| URL 7 | esp | 4 | 4 | 1 | 100 % |

| URL 8 | esp | 3 | 3 | 1 | 100 % |

Nº de URLs únicas = 8

Consultas por Propiedad o por Página

También se ven diferencias en la métricas (clicks, impresiones, etc) dependiendo de si la petición se realiza la consulta por Propiedad o por Página como comentamos en este artículo sobre informes utilizando la API de Google Search Console.

Por ejemplo si obtengo los datos entre dos fechas, solicitando las dimensiones "query" y "page" la API me devolverá una fila por cada par de "query"/"page" es decir, tendremos todos los datos desglosados. Por ejemplo así veríamos para un mismo site los datos según el tipo de agregado:

Datos, agregado por página, Tabla I

| query | page | clicks | impresiones | posición |

| KW1 | url_1.html | 10 | 100 | 1 |

| KW2 | url_3.html | 6 | 11 | 2 |

Datos, agregado por propiedad, Tabla II

| query | clicks | impresiones | posición |

| KW1 | 10 | 100 | 1 |

| KW2 | 6 | 11 | 2 |

Como podemos observar, al hacer la agregación por propiedad no estamos sumando clicks que se han generado en otras URLs, ls filas tachadas en la primera tabla, por eso normalmente es aconsejable si no se tiene del todo claro, usar los datos agrupados por página, sobretodo si queremos medir clicks e impresiones.

Como ves nos devuelve 10 filas, pero ahora tenemos menos URLs únicas que

antes, ya que par una misma URL hay tres filas diferentes y el límite

devuelto por la API o el interface web es por número de filas no de URLs.

Cuantas más dimensione, menos URLs únicas

Y esto debemos aplicarlo a cada dimensión, como por ejemplo los térmios de búsqueda, que reducirán mucho más el número de URLs únicas, ya que para cada URL normalmente hay muchas más KWs que países vistos en el ejemplo.

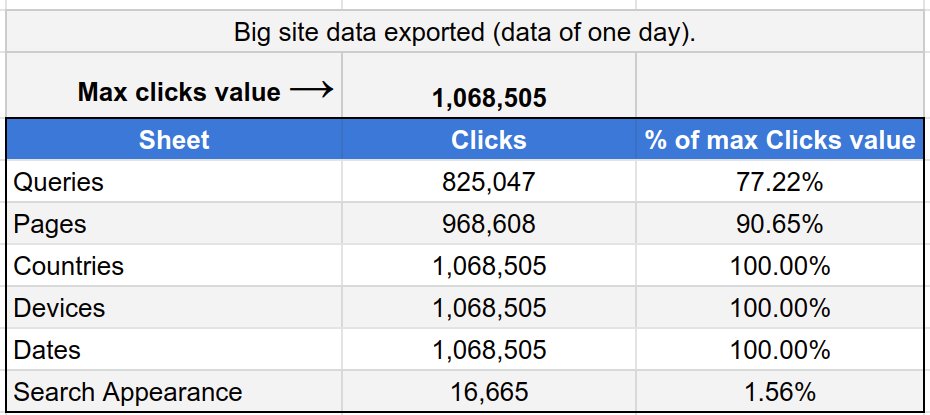

Y esto también afecta el número de clicks devueltos, sobretodo en sites muy grandes, muy impoirtante ;)

Por ejemplo, dependiendo de qué dimensión solicites devolverá más o menos clicks, como ya comenté en Twitter a Jhon Mueller

Ha sido breve, pero quería exponerlo al ver tanta duda, o mejor dicho ignorancia sobre esto, a muchas personas