Diferencias entre la exportación de datos de Search Console usando BigQuery o usando la API

Publicado por Lino Uruñuela el 28 de febrero del 2023

- Características de la exportación de Search Console a BigQuery

- Exportar todos los datos de Search Console a BigQuery

- Tamaño de los datos de Search Console en BigQuery

- Comparativa de datos entre la nueva exportación a BigQuery y los datos via API

- Conclusiones

La pasada semana Google anunció algo que, al menos desde este blog, hemos reivindicado y solicitado muchas veces, la posibilidad de exportar todos los datos que Search Console tiene sobre nuestro site.

Tal como dijeron en el blog oficial de Search Console, ahora es posible obtener todos los datos del informe de rendimiento, absolutamente todos, esto incluye datos de clicks, impresiones, posición para todas las kws, incluso las anonimizadas, por supuesto no contendrán la kw por la que el usuario llegó, pero sí contabilizará los clicks.

Otro punto importante, sino el más importante, es que ahora podemos descargar los datos sin límite de filas por combinación de dimensiones, cosa que anteriormente, tal como publiqué aquí, no era posible obtener todos los datos ya que estaba limitado a 50.000 filas por cada combinación de dimensiones. De esta forma evitaremos muchos de los problemas que aquí hemos venido contando!!

No todo es perfecto, y es que el método de exportación es bastante limitado, solo permite exportar los datos a BigQuery, la base de datos por excelencia de Google. Esto tiene sus pros y sus contras, pero sin entrar en grandes cuestiones técnicas listo algunas características.

Características de la exportación de Search Console a BigQuery

- Los datos se exportan diariamente automáticamente.

Si queremos mantener los datos en BigQuery, no tenemos que hacer nada, se exportará automáticamente cada día. - Existen tres tablas:

- "ExportLog": que nos muestra el estado del volcado diario

- "searchdata_url_impression": dónde tenemos los datos agregados tanto por "page" como por "query", es decir, aquí tenemos todas las URLs, keywords disponibles de nuestros datos.

- "searchdata_site_impression": a diferencia de la anterior en esta tabla tenemos la dimensión "query", pero no URL, por lo que los datos hacen referencia a las métricas para una consulta dada, y en el campo de posición tomará la mejor posicón de la propiedad para una keyword concreta.

- La suma de clicks e impresiones en ambas tablas será la misma.

- Obtenemos TODOS los datos existentes sobre la aparición de nuestro site en las serps.

- Es obligatorio exportar los datos a BigQuery, lo que implica que debemos añadir nuestra tarjeta de crédito en una cuenta de facturación de Google Cloud.

- Es obligatorio, de momento, crear un proyecto en Google Cloud para cada propiedad de la que queramos los datos. Esto puede ser un gran inconveniente si trabajamos con la nube de Google y tenemos unos cuantos proyectos creados porque GCP tiene un límte de proyectos máximo que se pueden crear por cada usuario y podría imposibilitar que por ejemplo puedas crear un volcado por cada cliente que tengas, deberá realizarlo el propio cliente, con su cuenta de facturación en Google Cloud, algo que a algunos no les hará ninguna gracia.

- La cantidad de datos es muy grande, tanto que alguna consulta SQL "ingenua" cuando se disponga de muchos meses de datos podria accarrear gastos en la cuenta de Google Cloud.

Exportar todos los datos de Search Console a BigQuery

Pero sin duda, lo mejor, y lo que nos hará olvidar casi cualquier contra que veamos es la cantidad de datos que nos ofrece en comparación con los datos que podemos obtener mediante el interface WEB o mediante la API.

Hoy no quiero entrar en detalle de los campos que nos ofrece y cómo podemos manejarlos en nuestra propia base de datos, hoy solo quiero mostrar la gran cantidad de datos que antes nos estábamos perdiendo. Para ello voy a crear una tabla comparativa entre los datos obtenidos mediante el nuevo bulk export y los datos que antes obteníamos mediante la API y la web.

Al ser Experto de Producto en Google he tenido el privilegio de disfrutar esta nueva funcionalidad unas semanas antes de que lo hicieran público y fuesen dando acceso a cada vez más sites, por lo que tengo datos de más de 15 días, que serán suficientes para poder comparar con datos obtenidos mediante la API.

Tamaño de los datos de Search Console en BigQuery

Aquí dos datos significativos obtenidos tras ejecutar la nueva exportación durante un periodo de 17 días :

- Número de filas totales: 192,418,965

- Espacio en disco: 33.97 GB

Cómo pedéis observar, cuando el site es un site grande (entre uno y dos millones de usuarios diarios) estamos hablando de números enormes!

Comparativa de datos entre la nueva exportación a BigQuery y los datos via API

Los datos que vamos a ver a continuación son datos de un site muy muy grande, como he comentado anteriormente, este site tiene entre uno y dos millones de usuarios al día, por lo que seguramente no sean las mismas proporciones para la gran mayoría de webs, realizaré esta misma comparativa con datos de webs más pequeñas en los próximos días.

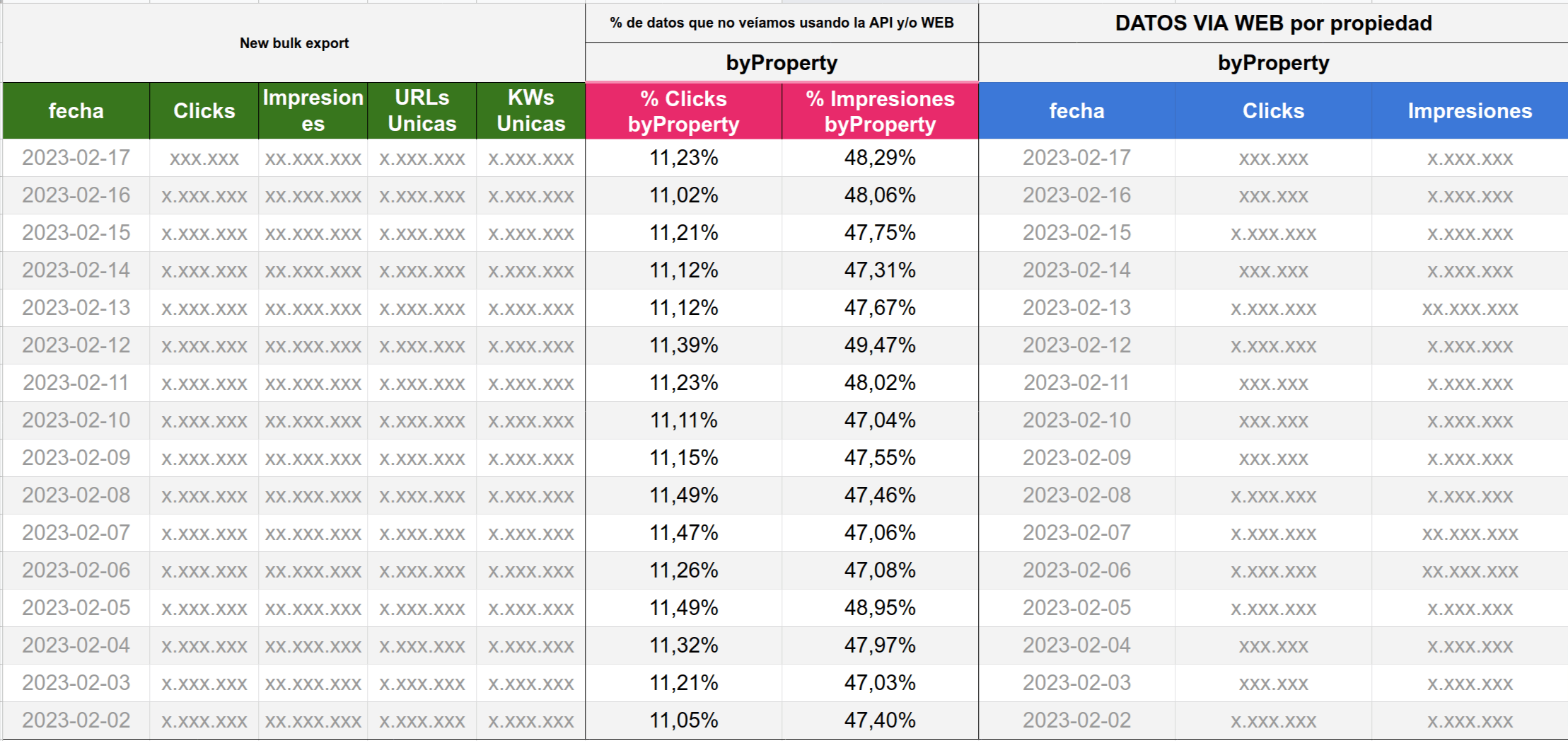

Comparativa de datos de la tabla byProperty (searchdata_site_impression)

Las tablas que muestro a continuación son datos extraidos mediante la API para un site muy grande, no puedo mostrar los números concretos de este site, pero sí el número de dígitos para hacernos una idea y sobretodo, el porcentaje de datos que vemos ahora y antes no veíamos.

Concretamente en esta tabla vemos:

- New bulk export: Son los datos extraídos mediante el nuevo método de exportación, por ejemplo, los clicks recibidos el día 17 son menos de un millón de clicks, el número de impresiones es mayor a 10 millones de impresiones, el número URLs únicas son enre 1 y 2 millones, y el de keywords únicas también entre 1 y 2 millones.

- DATOS VIA WEB por propiedad: Estos datos son obtenidos mediante la api, sin solicitar ni filtrar por las dimensiones de "query" o "page", este es el número que vemos encima de las gráficas de Search Console cuándo vemos los clicks o impresiones sin filtrar. Es el valor máximo de clicks que se pueden obtener tanto mediante la API como del interface WEB

- % de datos que no veíamos usando la API y/o WEB: esta columna muestra qué porcentaje de clicks y de impresiones representan los datos VIA WEB o API en relación a los clicks que recibimos con el nuevo método de exportación

Esto quiere decir que:

- Ahora disponemos de un 11% más de clicks diarios de los que podíamos ver antes ya fuese usando la API o ya fuese a través del interface WEB.

- Ahora disponemos de un 47% más de impresiones diarias que usando la API o el interface WEB.

Poniendo un ejemplo, si para un día concreto antes veíamos que teníamos 100 clicks y 1000 impresiones utilizando la API, ahora obtendríamos 110 clicks y 1500 impresiones

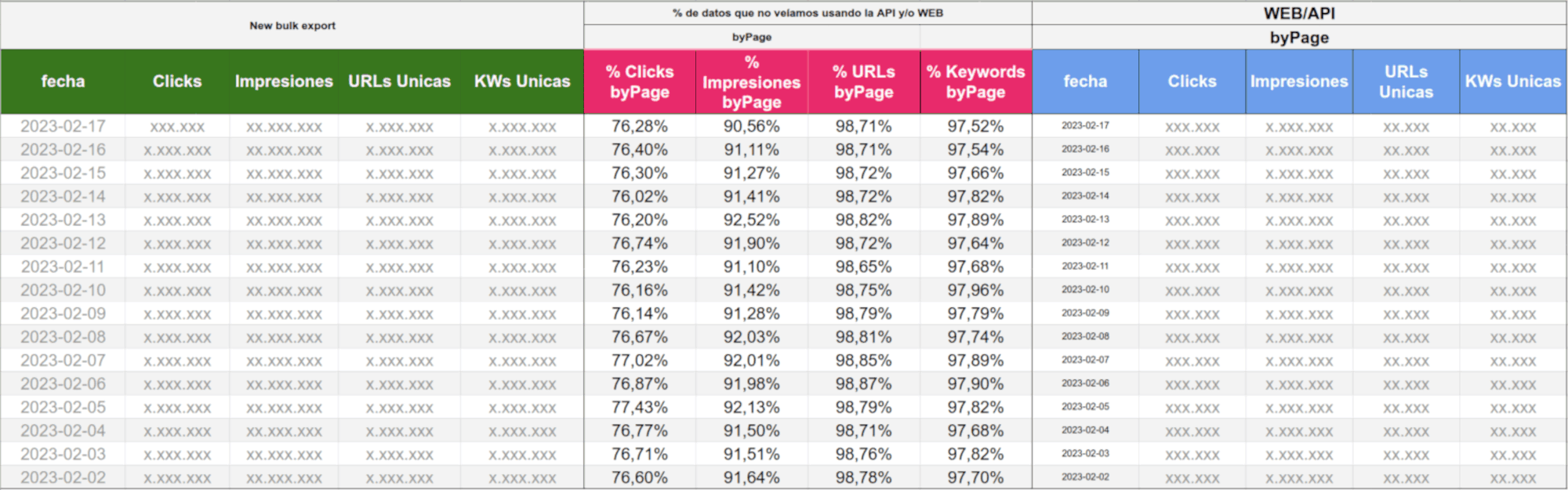

Comparativa de datos de la tabla byPage (searchdata_url_impression)

Si os parece muy grande la diferencia entre los clicks y las impresiones obtenidas con el nuevo método respecto a los datos extraídos de la API cuando solicitamos datos sin dimensión de page ni dimensión de query (la manera en que más clicks se obtienen tanto en la API como en la web de Search Console pero sin datos de urls o kws), agarraros fuerete que ahora viene lo más gordo ya que cuando solicitamos la dimensión page o filtramos por ella la brecha de datos es abismal!.... Recordar que la dimensión page es uno de los filtros más habituales.

En la web de Search Console o usando la API cuando solicitamos o filtramos por URL estamos perdiendo el 76% de los clicks, el 92% de las impresiones, el 98% de las URLs y el 97% de las keywords. A falta de un análisis más en profundidad hay que tener en cuenta que muchos de estos datos son generados por búsquedas que tienen una sola impresión y ningún click, pero este análisis lo dejaremos para otro post.

Algunas conclusiones

Como podemos observar la diferencia de los datos es asombrosa, destaquemos lo más relevante:

- Más del 76% de los clicks no son contabilizados cuando utilizamos la API o el interface web y solicitamos datos de "page" y "query" o filtramos por "page" o por "query".

- Más del 90% de las impresiones antes no eran contabilizadas al aplicar un filtro o al solicitar las dimensiones de "page" y "query"

- Más del 98% de las URLs que han recibido alguna impresión no eran mostradas al usar el interface web o la API.

- Más del 97% de las keywords no son mostradas cuando utilizamos el interface web o la API

Este ha sido el primer artículo que escribo sobre este nuevo método de exportación de los datos de Google Search Console, como te imaginarás si sigues este blog, no será el último dónde hablemos de estos datos, de cómo podemos sacarles el máximo provecho, cómo exportarlos de manera eficaz y también con qué hemos de tener cuidado.

Señor Muñoz (@senormunoz)hace Hace más de 2 años y 335 días

Lino, el 11% más de clicks y el 47% más de impresiones diarias ¿es algo constante o depende de cada sitio web?