Cuando restringes por robots.txt puedes aumentar el número de URLs indexadas

|

Llevo unos cuantos meses observando un comportamiento algo contradictorio al restringir URLs desde el robots.txt. Supuestamente en el robots.txt puedes restringir el acceso a los buscadores como Google, para así no indexar y que no se muestre en las búsquedas resultados que no te interesan.

Lo normal es pensar que cuando restringes URLs a través del robots.txt tu número de páginas indexadas en Google debería descender, pero no es así.

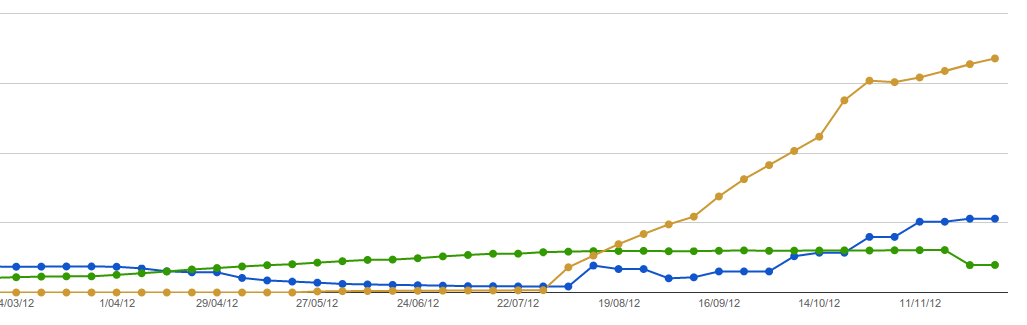

Como vemos el mismo día que restringimos por robots.txt muchas URLs vemos como las páginas indexadas aumenta igualmente!

Esta no es una coincidencia, lo he comprobado en unas cuantas webs y ocurre lo mismo. Podéis comprobarlo :)

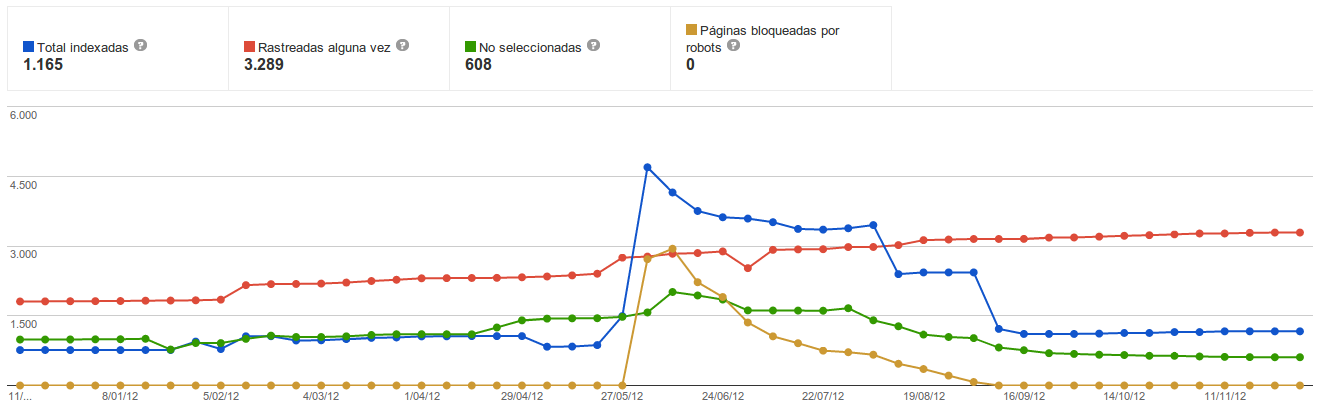

En este otro ejemplo, no es tan tan claro, pero vemos también como varia

Mi teoría

Pienso que Google asigna un Nº determinado de URLs indexables variable para cada web. Este Nº podria depender de la autoridad del dominio, quizás también use el Nº de URLs totales, para asignar más o menos número de URLs en su índice de cada site.

De esta manera se podría explicar por qué cuando restringimos por robots.txt el acceso a muchas URLs vemos un incremento en el número de URLs indexadas en Google.. Vemos como las URLs seguidas alguna vez (color rojo) sigue con su tendencia, no varía, Google rastrea todo lo que puede, pero en cambio los demás datos varían claramente al modificar el robots.txt.

Si Google por ejemplo tuviese un cupo de URLs para un site con un valor de 1000, entre esas 1000 hay 800 URLs no seguidas (meta noindex, mala calidad, duplicado, errores desconocidos, etc) quedarían sólo 200 para ser indexables y la proporción de URLs "malas" y URLs indexables no es suficiente para aumentar el cupo con lo que tu número de URLs indexables seguirá igual a 200.

Si conseguimos descender el número de URls de mala calidad que Google detecte , podremos hacer que el ratio entre NºURLs indexables y NºURLs del cupo aumente y puede que sea esto lo que hace que Google recalcule ese nuevo cupo para las URLs indexables.

Puede que Google no contemple este ratio entre urls indexables y urls no seguidas, pero está claro que algo tiene que ver con el robots.txt por lo que a mi parecer tiene que ser que Google asigna un cupo de URLs en su índice de tu site. Y es este número el que debemos intentar aumentar y/o regular.

¿Podría haber diferencias relevantes entre usar un meta noindex y usar la restricción por el robots.txt? Yo con el meta noindex no he visto este comportamiento...

Christian Oliveira (@)hace Hace más de 11 años y 147 días

Muy raro, no? Cuando bloqueas URLs en el robots el número de indexadas pasa a ser superior al número de rastreadas (lo que en teoría no tiene sentido). Hace unos extraños y luego como que se normaliza, y las bloqueadas por robots.txt bajan a 0 (les has quitado el bloqueo?)

En cualquier caso, el robots.txt no impide que Google indexe esas URLs, sólo que no las rastree. Si hay enlaces las "indexa" igual (indexa sólo la URL) sin ningún tipo de información más que la URL y los anchor de los enlaces que haya a esa URL). En cambio el deja a Google rastrear la página pero no indexarla (lo contrario que el robots).

Errioxa (@)hace Hace más de 11 años y 147 días

@Christian lo que comentas de número de indexadas superior al rastreadas está claro que no nos ofrece todos los datos, pero ya te digo que este comportamiento no lo he visto en esta web, en esta hice la prueba poco tiempo, la he vuelto a realizar ahora. Pero en otros sites pasa lo mismo! no creo que sea coincidencia...

Como bien dices no impide que Google indexe esas URLs, concretamente no indexará su contenido, ni lo leerá pero pueden estar en su índicede una manera indirecta, si las linkas lo suficiente hasta aparecerán en las serps sin título ni descripción, pero... ¿será que los datos para ofrecer ese resultado son los que tienen guardado en el índice de links de otras webs y no en el nuestro?

Algo ocurre, hacer la prueba y así compartimos experiencias :)

Saludos

Errioxa (@)hace Hace más de 11 años y 147 días

@Dario Cedeño si me pones un poco más de gráfica igual se puede ver algo...

Y sobretodo depende de lo que estés haciendo en tu web, si la acción ha sido aislada o hubo más implementaciones de otro tipo en el site. También si has hecho la prueba de cambiar el noindex por robots.txt...

David Carrero Fernandez-Baillo (@)hace Hace más de 11 años y 133 días

Yo ultimamente en algunas web estoy optando por incluir url en robots.txt pero además restringir el acceso por IP, así además de no indexarse google realmente no puede acceder y así evito la mirada indiscreta del gran hermano.

Errioxa (@)hace Hace más de 11 años y 133 días

@David ten cuidado que igual te podría acusar de cloaking ;)

JavierM (@)hace Hace más de 11 años y 112 días

Olvidé comentar que en el apartado de sitemap de GWT prácticamente todas las URL's que deben indexarse lo han hecho:

797 Enviado

794 Indexadas

JavierM (@)hace Hace más de 11 años y 112 días

Perdón... el gráfico:

Javier Lorente (@)hace Hace más de 11 años y 77 días

X-Robots-Tag: noindex + robots.txt no indexaría la URL, no?

Errioxa (@)hace Hace más de 11 años y 76 días

La URL la guardará siempre si tiene algún link entrante creo yo, y si recibe suficientes enlaces se posicionará.

Sólo desde WMT puedes hacer que desaparezca.

Javier (@)hace Hace más de 11 años y 67 días

Gracias por los comentarios, lo que extraña es que parece que sí se van borrando (lentamente), pero las que aparecen como no eliminadas (y algunas que vuelven a aparecer al tener enlaces) no aparecen usando 'cache:'

Javier (@)hace Hace más de 11 años y 67 días

Gracias por los comentarios, lo que extraña es que parece que sí se van borrando (lentamente), pero las que aparecen como no eliminadas (y algunas que vuelven a aparecer al tener enlaces) no aparecen usando \\\'cache:\\\'

Javier Lorente (@javier_lorente)hace Hace más de 9 años y 34 días

Tengo proyectos con xrobots tag con noindex que despues de meses y meses... la URL sigue indexada si hago un site:.. tiene enlaces, lo que dices.

Javier Lorente (@javier_lorente)hace Hace más de 9 años y 34 días

Tengo proyectos con xrobots tag con noindex que despues de meses y meses... la URL sigue indexada si hago un site:.. tiene enlaces, lo que dices.

Javier Lorente (@twitter.com/javier_lorente)hace Hace más de 9 años y 34 días

Tengo proyectos con xrobots tag con noindex que despues de meses y meses... la URL sigue indexada si hago un site:.. tiene enlaces, lo que dices.

Javier Lorente (@twitter.com/javier_lorente)hace Hace más de 9 años y 34 días

AH! Lo bueno sería contar las posicionadas Lino.. no las indexadas :-)

Javier Lorente (@)hace Hace más de 6 años y 120 días

Creo que deberíamos empezar a diferenciar ya de una vez por todas "indexadas" y "en el index server".

Personalmente por indexadas entiendo rastreadas y preparadas para posicionar o rankear, urls preparadas para ser devueltas en una serp tras una determinada query de búsqueda.

Sin embargo, "estar en el index server", es simplemente estar en el listado de "URLs pendientes de rastrear" si no hay nada que lo impida.

Creo que el informe del estado de indexación de Google Search Console, muestra las URLs en el index server y que parte de las "deshabilitadas por robots" y de las "indexadas" son las mismas, ojo que digo parte porque según mis pruebas solo pasa con una parte de URLs. Básicamente sólo las que tienen suficiente fuerza y entidad propia como para continuar en la "lista del index server" pese a estar en robots.txt. Pero esto daría para otro post aparte.

Pon algo para enterarnos de las respuestas de los comentarios :)

Lino Uruñuela (@)hace Hace más de 6 años y 116 días

@Javier Lorente mañana te contesto poco a poco, de momento la sugerencia de "Pon algo para enterarnos de las respuestas de los comentarios " la acabo de implementar, regalo de Reyes ;). A ver si así facilita la conversación ;)

Por cierto, dime si te llega, estás en modo tester :D