¿Cuál es la mejor manera de desindexar URLs?

Publicado el lunes 10de junio del 2013, By Lino Uruñuela

Hoy debatiendo en una lista de correo me ha hecho pensar en cuál es el mejor método para desindexar una url, y claro todo depende de en cómo definamos lo que es desindexar una página y para que lo estamos usando....

Empezemos por definir que entendemos por desindexar

Hoy debatiendo en una lista de correo me ha hecho pensar en cuál es el mejor método para desindexar una url, y claro todo depende de en cómo definamos lo que es desindexar una página y para que lo estamos usando....

- ¿Que no se muestren en los resultados?

- ¿Que lo marque WMT?

- ¿Que GoogleBot no entre nunca?

Si entendemos por desindexar que no la muestre en los resultados entonces la mejor opción es la herramienta de WMT donde puedes desindexar hasta directorios, el meta noindex también consigue ese efecto, pero mucho menos rápido ya que ha de rastrear cuando le toque url a url. Lo malo de esta opción es que no puedes crear ningún tipo de regla con expresiones regulares y la mayoría de los casos son miles de urls las que queremos desindexar y no se podría ir una a una. Además no garantizamos que el bot no acceda, sólo que no lo mostrará en sus resultados y su caché.

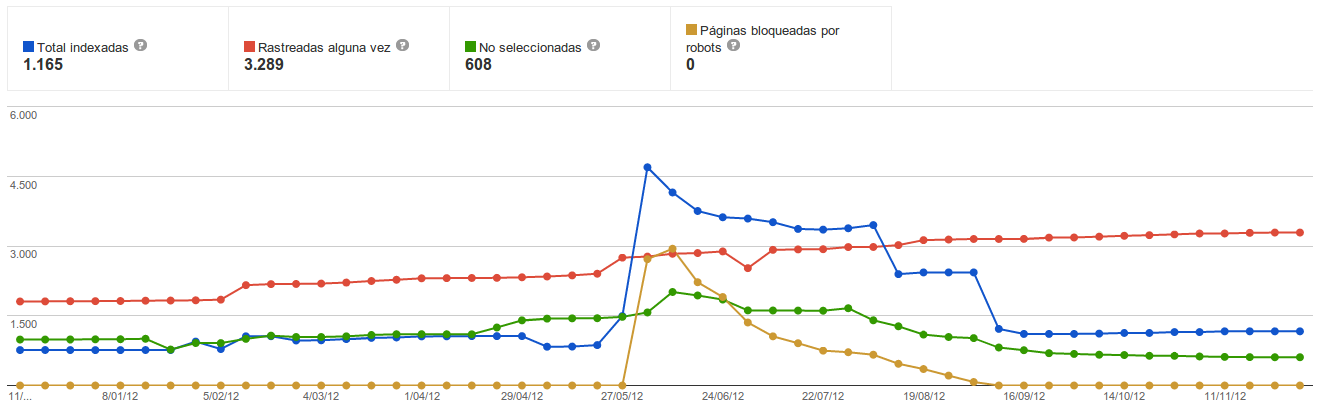

Si consideramos por desindexar que en WMT descienda la gráfica debemos tener mucho cuidado en que pensamos, porque realmente creo que estas gráficas pueden representar algo hoy y otra cosa mañana

Google de vez en cuando hará limpia de cosas y antes que sus datos de índices borrará datos de herramientas como esta y pondrá la cuenta a 0.... es muy raro que el número de urls bloquedas de repente descienda de repente si las reglas son las mismas y por lo tanto, sí o sí, el número de urls bloquedas como mínimo será el mismo... nunca menos, pero vemos como NO refleja la realidad.

Google de vez en cuando hará limpia de cosas y antes que sus datos de índices borrará datos de herramientas como esta y pondrá la cuenta a 0.... es muy raro que el número de urls bloquedas de repente descienda de repente si las reglas son las mismas y por lo tanto, sí o sí, el número de urls bloquedas como mínimo será el mismo... nunca menos, pero vemos como NO refleja la realidad.

La 3ª opción, que GoogleBot no acceda y por lo tanto no lea lo que hay. Para esto lo mejor es usar robots.txt ya que nos aseguramos que el Bot no entra ni entrará y no sabrá lo que hay.

En sus índices estará si tiene los suficientes enlaces entrantes, entonces aunque no sepa lo que hay lo mostrará como resultado. Podríamos concluir que sí está indexada porque las guarda en sus índices.

Esta tercera opción para mi es la mejor cuando quieres restringir cosas molestas y riesgos por urls de baja calidad y duplicidad, por qué

- Estás completamente seguro que Google no entra, no podrá valorar lo que hay y no lo hará.

- Te evitas consumo de máquina inecesario. Si pones un meta noindex el bot hará la petición y luego leerá o no el contenido, pero la petición la hace, no la indexa pero puede valorarla y seguir los enlaces de

-

- paginaciones

- ordenaciones

- ordenaciones de paginaciones

- filtros

- ordenaciones de filtros

- paginaciones de filtros

- paginaciones de ordenaciones de filtros

- etc etc

esto puede estar ocupando a tu servidor el 80-90% de sus recursos y tiempo, mirar los logs y flipar.

-

- Aunque tarda más en ser representado con el comando site, no quiere decir que no las acabe desindexando, una muestra puede ser la gráfica de arriba, con el tiempo bajan, aunque parece más razonable que como también bajan el número de URLs indexadas sea por una limpia en los datos de la herramienta, quizás hasta de sus índices....

Pero no se ve tan reflejada en la otra gráfica del post... por lo cual y con casos muy contradictorios lo único que sé es de que no puedo fiarme demasiado de WMT, puede que de síntomas de cosas en muchos casos, pero con lo del número de urls indexadas.... no me fio un pelo de sus datos.

La verdad es que me podría extender y contradecir durante párrafos y párrafos (hay que ser muy simple para ser siempre coherente), pero no sabría a ciencia cierta casi nada, sólo son intuiciones e ideas abstractas que rozan mi cabeza, pero me da que Panda mucho tiene que ver con el número de urls de baja calidad que tienes en tu sitio, entendiendo por "de baja calidad" lo que Google quiera entender....

Errioxa (@)hace Hace más de 12 años y 241 días

@Dani me alegro leerte :)

Sobre los errores 410 y 404, yo estaba pensando en miles de URLs a restringir, y dar miles de errores 404 o 410 no me gusta nada. No sé si será malo, pero sé que bueno no es :p

Como bien dices por el robots.txt es cortar de raíz con el problema, mientras que con las otras opciones como los metas el bot seguirá haciendo peticiones, para esto puedes mirar los logs y comprobarlo. Encima como le metas un noindex,follow lo hará con la misma frecuencia...

Sobre las 301 y 302, no sé muy bien que decirte... sé que hace poco Google tuvo problemas con los 301 y hasta lo reconoció, yo lo vi claramente en los logs como de un día para otro hacía muchas menos peticiones a estas urls que dan 301 ya que lo monotorizo. Y por lo que veo, sigue haciéndolas y checkeándolas continuamente!! raro, pero así es...

Dani Pinillos (@)hace Hace más de 12 años y 241 días

Si te dará un montón de notificaciones de error en WMT y tienes que ir borrando de mil en mil pero para eliminarlas del índice es lo único que conozco que lo quite rápido :(

Interesante lo del crawleo de las redirecciones. Si sabía que el año pasado mas o meos tuvo problemas con las redirecciones pero no que no las seguia.

El nuevo seo está en los logs :D

Errioxa (@)hace Hace más de 12 años y 241 días

El nuevo SEO no sé, pero las nuevas métricas seguro que sí

Derlis H. (@)hace Hace más de 12 años y 234 días

Realmente hay mucho contenido para realizar un posicionamiento web o blogs hay mucha maneras de obtener los resultados que deseamos no es fácil el trabajo de un SEO todo tiene sacrificio

Optimización web

Derlis H. (@)hace Hace más de 12 años y 234 días

Realmente hay mucho contenido para realizar un posicionamiento web o blogs hay mucha maneras de obtener los resultados que deseamos no es fácil el trabajo de un SEO todo tiene sacrificio

Optimización web