Diferencias entre url indexada y url accesible

Publicado el 18 de marzo del 2019 por Lino Uruñuela

Siempre ha habido debates sobre cómo indexar urls en Google, ¿cuántas urls tiene Google indexadas de mi web? ¿cuántas urls crawleadas tiene mi site? ¿es mejor usar el robots.txt o es mejor usar el meta noindex para no indexar determinadas urls?.... el debate continuará durante mucho tiempo, pero lo primero que debemos hacer es intentar hablar todos en el mismo idioma.

Los términos indexable, accesible, rastreable, etc se mezclan y distorisionan por todo el mundo, yo el primero, y deberíamos intentar consensuar determinada terminología SEO.

Creo que la mejor manera de llegar a una nomenclatura general es usar la misma que usa Google, concretamente en el nuevo Google Search Console.

Por ejemplo, yo hasta que no salió el nuevo GSC, en mi cabeza, una url bloqueada por robots.txt no era una url indexada. Y eso lleva a confusiones a la hora de interpretar algunos datos.

Hasta hace algo más de un año, antes de que viera la luz la nueva versión de Search Console, tenia la duda de si al bloquear por robots.txt determinadas urls Google indexará, o al menos rastreará, otras URLs que antes no rastreaba. Y no estaba mal pensado, pero no era correcta esa hipótesis.

Las primeras dudas sobre tal hecho fueron con datos de logs del servidor. No veía ese crecimiento en urls rastreadas que antes no hubiese rastreado, es decir, no parecía que Google usase el tiempo que gastaba en las urls que restringí por robots.txt en otras urls a las que antes no accediera.

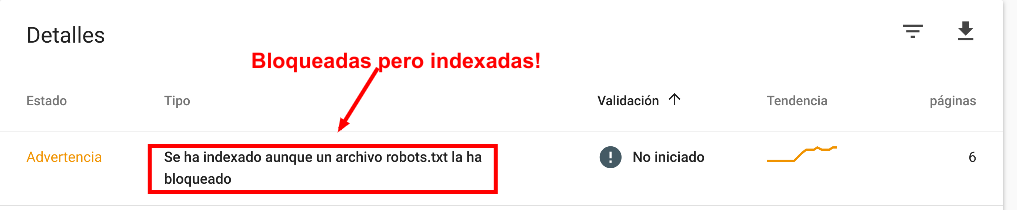

Cuando salió el nuevo Search Console lo vi claro, concretamente en el informe de cobertura, las urls a las que no se le permite acceder mediante robots.txt las cataloga como "indexables".

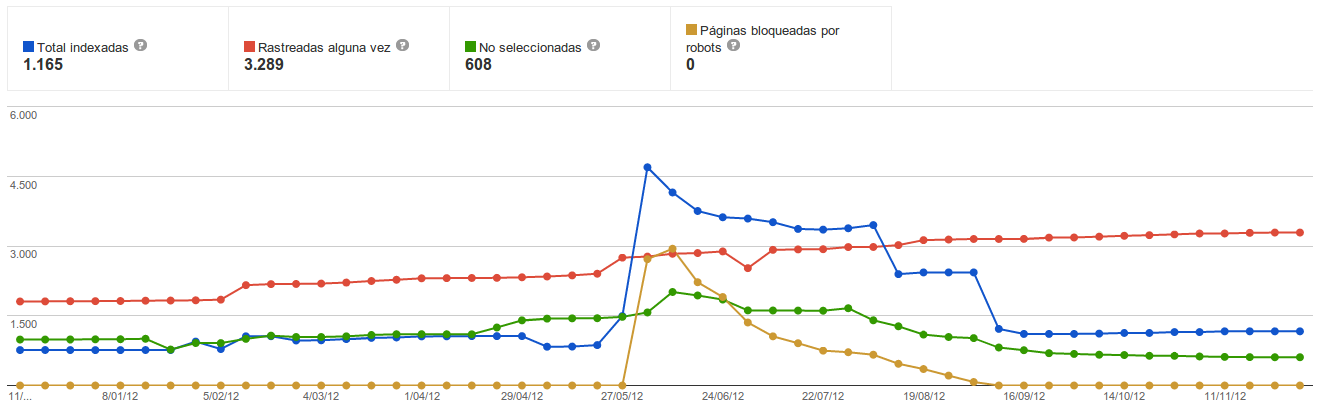

Y ahora cobra sentido las gráficas que veníamos viendo en el viejo Search Console cuando restringimos urls mediante el robots.txt.

Veíamos un aumento de URLs indexadas, casi las mismas que habíamos restringido por robots.txt. Ese aumento en el número de urls indexadas por Google no era porque Google indexara otras URLs, sino que Google ahora al no poder acceder a esas urls bloqueadas por robots.txt las marca como "indexadas" solamente con tener suficientes enlaces entrantes ya que el contenido no puede verlo.

Antes de bloquearlas no eran "indexadas" porque Google accedía a esas urls y no creía que su contenido fuese suficientemente relevante para añadirlas a su índice. Ahora como no puede acceder no puede ver ni el contenido ni los metas (si los tuviera) por lo que la marcará como indexable, pero no siempre, solo si tiene suficientes enlaces, por eso vemos en el nuevo GSC que hay warnings con urls bloqueadas por robots incluídas en el índice y también en excluidas por el mismo motivo.

Sobre este tema en concreto volveré en otro post profundizando en la diferencia de urls bloqueadas Vs aumento de urls indexadas, pero ahora vamos a intentar esquematizar un poco los posibles estados de una url y su nomenclatura

Las URLs de cara a SEO se podrían categorizar como:

- Accesibles (rastreables)

Google puede acceder y ver su contenido.

Aquellas URLs a las que Google puede acceder, es decir, aquellas URL que no están restringidas por robots.txt (por defecto).

Las URLs Accesibles pueden ser:

- Indexable:

Aquellas con valor index en el meta robots (por defecto).

No por ser indexable quiere decir que sea indexada, sino que podría serlo, depende de Google y su algoritmo decidir si la indexa o no.

- No Indexable

Con meta robots = "noindex"

Google accede a la url, ve su contenido, y parte del contenido es el meta robots, si contiene el valor "noindex" indicará a Google que esta URL no puede ser mostrada en sus resultados.

Google denomina a las URLs que no puede o no quiere mostrar en sus resultados como URL no indexada (o excluída), lo que no quiere decir que no acceda a ella con regularidad.

Posiblemente aquí deberíamos meter todas las urls que no responde con un código de estado 200. Ya que son accesibles (nada en el robots se lo impide) pero no son indexables,ya que o bien son páginas de error, o son redirecciones.

- Indexable:

- No Accesibles

Aquellas URLs a las que Google NO puede acceder porque se lo prohibimos, es decir, aquellas bloqueadas mediante robots.txt.

Al no poder acceder, Google no podrá ver su contenido, ni tampoco sus meta robots, ni ninguno otro. Ni siquiera podrá saber si da una redirección 301 o un error 404.

- Indexables

Todas, ya que si no puede acceder a la url no podrá ver el valor del meta robots.

Recordemos que solamente este meta con valor "noindex" vuelve a una url no indexable, ya sea añadida en el HTML, como por cabeceras X-Robots-Tag

- Indexables

Espero que este esquema y resumen sirva para aclarar un poco la nomenclatura para cada estado posible de una url y su posible indexación en Google.

Os animo a corregir / criticar, completar y usar esta nomenclatura, hacerlo lo más parecido a como lo hace Google podremos entendernos mejor a la hora de hablar de indexación y rastreo.

Juan Francisco Gancia (@)hace Hace más de 6 años y 282 días

Excelente artículo, gracias!

Te encuentro de casualidad por un post de hace 10 años.